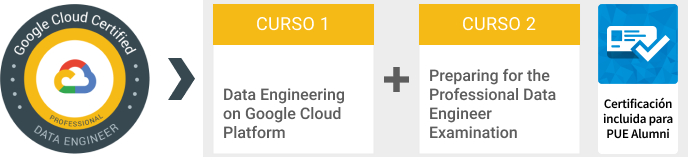

Google Cloud Data Engineering - Professional Data Engineer Certification

Presencial / Live Virtual Class

Presencial / Live Virtual Class

34 horas

34 horas

2300.00 €

2300.00 €

CERTIFICACIÓN INCLUIDA

Para miembros del colectivo PUE Alumni

Actualmente no existen convocatorias programadas para estos cursos

Acerca de este curso

El presente curso está orientado para que el alumno obtenga las habilidades y conocimientos necesarios para ser un Ingeniero de Datos profesional de Google Cloud, un perfil laboral que habilita la toma de decisiones basada en datos mediante la recopilación, transformación y publicación de los mismos. También es capaz de diseñar, construir, operar, asegurar y monitorizar los sistemas de procesamiento de datos con un énfasis particular en la seguridad y el cumplimiento; la escalabilidad y la eficiencia; la fiabilidad y la fidelidad; y la flexibilidad y la portabilidad. Además, es capaz de aprovechar, desplegar e implementar continuamente modelos de machine learning preexistentes.

El primer módulo de este curso proporciona a los alumnos una introducción al diseño y construcción de sistemas de procesamiento de datos en Google Cloud Platform. Mediante la combinación de demos y laboratorios, los alumnos aprenderán a como diseñar sistemas de procesado de datos, construir canales end-to-end, analizar datos y realizar machine learning. Esta parte del curso también cubre datos estructurados, no estructurados y transferencia continua.

El segundo y último módulo del curso se focaliza en la preparación del examen oficial de certificación Professional Data Engineer, cuya superación verifica que un profesional está totalmente cualificado para ejercer como ingeniero de datos profesional de Google Cloud en un entorno empresarial.

La completa preparación que ofrece este módulo se consigue mediante el ensayo de habilidades útiles, que incluyen razonamiento para preguntas de examen y comprensión de casos, consejos de utilidad, revisión de temas del curriculum de Infraestructura y la realización de un Practice Test, una simulación del examen de certificación asociado a este curso.

PUE es Official Training Partner de Google Cloud autorizado por dicha multinacional para impartir formación oficial en sus tecnologías.

A quién va dirigido

Este curso está dirigido a desarrolladores responsables de la administración de las transformaciones big data, incluyendo:

- Extracción, carga, transformación, limpieza y validación de datos.

- Diseño de pipelines y arquitecturas para procesamiento de datos.

- Creación y administración de machine learning y modelos estadísticos.

- Realizar consultar a dataset, visualización de resultados de consultar y creación de reportes.

Esta formación también está dirigida a profesionales de Cloud que tienen la intención de realizar el examen de certificación de Professional Data Engineer, quienes para sacar el máximo provecho posible del curso deben tener:

- Completado el curso Google Cloud Fundamentals: Big Data & Machine Learning o experiencia equivalente.

- Competencia básica con lenguaje de consultas común como SQL.

- Experiencia con modelado, extracción, transformación y carga de datos.

- Competencia en desarrollo de aplicaciones utilizando un lenguaje de programación común como Python.

- Familiaridad con Machine Learning y/o estadística.

Objetivos del curso

Al finalizar el curso, los alumnos serán capaces de:

- Diseñar y construir sistemas de procesamiento de datos en Google Cloud Platform.

- Procesar datos batch y transferencia continua implementando canales de autoescalado de datos en Cloud Dataflow.

- Conseguir información de negoción de datasets enormes utilizando Google BigQuery.

- Evaluar y predecir utilizando modelos machine learning utilizando Tensorflow y Cloud ML.

- Hacer uso de datos no estructurado utilizando Spark y APIs ML en Cloud Dataproc.

- Habilitar información instantánea de la transferencia continua de datos.

- Proporcionar información, consejos y sugerencias de cara a la realización del examen de certificación asociado al presente curso.

- Revisar en profundidad varios ejemplos de estudio de casos.

- Revisar cada sección del examen abarcando conceptos de alto nivel para generar la suficiente seguridad y confianza para afrontar el examen de certificación.

- Identificar aquellas áreas de estudio en las deban mejorar.

Certificación incluida

Este curso es el recomendado para la preparación del siguiente examen de certificación oficial valorado en 222,45€ (IVA incl.), cuyo coste (una convocatoria) está incluido en el precio del curso para todos los miembros del programa PUE Alumni:

La superación de este examen es requisito imprescindible para obtener la Professional Data Engineer Certification.

PUE es centro certificador oficial Kryterion facilitando la gestión del examen al candidato. El alumno podrá realizar su certificación, bien en nuestras instalaciones o, si lo prefiere, a través de la opción Kryterion’s online-proctoring (OLP) solution, que le permite atender la certificación oficial de Google Cloud desde cualquier ubicación con una simple conexión a internet.

Contenidos

Módulo 1: Data Engineering on Google Cloud Platform

Introducción a la ingeniería de datos

- Conocer el rol de un ingeniero de datos.

- Analizar los desafíos de la ingeniería de datos.

- Introducción a BigQuery.

- Data Lakes y Data Warehouses.

- Demostración: Federated Queries con BigQuery.

- Bases de datos transaccionales vs Data Warehouses.

- Demostración web: Encontrar PII en su dataset con la API DLP.

- Asociación efectiva con otros equipos de datos.

- Gestionar el acceso a los datos y la gobernanza.

- Creación de pipelines listos para producción.

- Revisión del caso de estudio personalizado de GCP.

- Laboratorio: análisis de datos con BigQuery.

Creación de un Data Lake

- Introducción a Data Lakes.

- Almacenamiento de datos y opciones ETL en GCP.

- Creación de un Data Lake con almacenamiento en Cloud.

- Demostración opcional: optimización de costes con las clases de Google Cloud Storage y las funciones Cloud.

- Securizar el almacenamiento en Cloud.

- Almacenar de manera ordenada todo tipo de datos.

- Video demostración: ejecución de federated queries en ficheros ORC y Parquet en BigQuery.

- Cloud SQL como un Data Lake relacional.

- Laboratorio: Carga de datos procedentes de un taxi en Cloud SQL.

Creación de un Data Warehouse

- El Data Warehouse moderno.

- Introducción a BigQuery.

- Demostración: Query TB+ de datos en segundos.

- Introducción.

- Carga de datos.

- Video demostración: Consulta de Cloud SQL desde BigQuery.

- Laboratorio: carga de datos en BigQuery.

- Estudio de esquemas.

- Demostración: estudio de Datasets públicos de BigQuery con SQL utilizando INFORMATION_SCHEMA.

- Diseño de esquemas.

- Campos anidados y repetidos.

- Demostración: campos anidados y repetidos en BigQuery.

- Laboratorio: trabajar con datos JSON y Array en BigQuery.

- Optimización con particionamiento y clustering.

- Demostración: Tablas particionadas y clusterizadas en BigQuery.

- Vista previa: transformación de datos Batch y Streaming.

Introducción a la creación de Batch Data Pipelines

- EL, ELT, ETL.

- Consideraciones de calidad.

- Realizar operaciones en BigQuery.

- Demostración: ELT para mejorar la calidad de los datos en BigQuery.

- Deficiencias.

- ETL para resolver problemas de calidad de datos.

Ejecutar Spark en Cloud Dataproc

- El ecosistema de Hadoop.

- Ejecutar Hadoop en Cloud Dataproc.

- GCS en lugar de HDFS.

- Optimización de Dataproc.

- Laboratorio: ejecución de Apache Spark jobs en Cloud Dataproc.

Procesamiento de datos Serverless con Cloud Dataflow

- Cloud Dataflow.

- El valor del Dataflow para los clientes.

- Dataflow Pipelines.

- Laboratorio: Un Dataflow Pipeline simple (Python/Java).

- Laboratorio: MapReduce en Dataflow (Python/Java).

- Laboratorio: Side Inputs (Python/Java).

- Plantillas de Dataflow.

- Dataflow SQL.

Administrar Data Pipelines con Cloud Data Fusion y Cloud Composer

- Crear de manera visual Batch Data Pipelines con Cloud Data Fusion.

- Componentes.

- Descripción general de la UI.

- Creacion de un Pipeline.

- Estudio de datos con el uso de Wrangler.

- Laboratorio: creación y ejecución de un gráfico pipeline en Cloud Data Fusion.

- Orquestar el trabajo entre los servicios de GCP con Cloud Composer.

- Apache Airflow Environment.

- DAGs y Operadores.

- Programación de un Workflow.

- Demostración opcional: carga de datos activada por eventos con Cloud Composer, Cloud Functions, Cloud Storage y BigQuery.

- Monitorización y Logging.

- Laboratorio: Introducción a Cloud Composer.

Introducción al procesamiento de datos streaming

- Procesamiento de datos streaming.

Mensajería Serverless con Cloud Pub/Sub

- Cloud Pub/Sub.

- Laboratorio: Publicar datos streaming en Pub/Sub.

Características de Cloud Dataflow Streaming

- Características de BigQuery Streaming.

- Laboratorio: Streaming Data Pipelines.

Características de BigQuery Streaming y Bigtable de alto rendimiento

- Características streaming de BigQuery.

- Laboratorio: Streaming Analytics y Dashboards.

- Cloud Bigtable.

- Laboratorio: Streaming Data Pipelines en Bigtable.

Funcionalidad y rendimiento avanzados de BigQuery

- Funciones de ventana analíticas.

- Uso de cláusulas With.

- Funciones GIS.

- Demostración: mapear los códigos postales de más rápido crecimiento con BigQuery GeoViz.

- Consideraciones de rendimiento.

- Laboratorio: Optimización de consultas BigQuery para mejorar el rendimiento.

- Laboratorio opcional: creación de tablas particionadas por fecha en BigQuery.

Introducción a la analítica y la IA

- ¿Qué es la IA?

- Del análisis de datos Ad-hoc a las decisiones basadas en datos.

- Opciones para modelos ML en GCP.

APIs de modelado ML preconstruidas para datos no estructurados

- La dificultad de los datos no estructurados.

- APIs de ML para el enriquecimiento los datos.

- Laboratorio: uso de la API de lenguaje natural para clasificar texto no estructurado.

Análisis Big Data con Cloud AI Platform Notebooks

- ¿Qué es un Notebook?

- BigQuery Magic y Ties to Pandas.

- Laboratorio: BigQuery en Jupyter Labs para la plataforma IA.

Pipelines ML en producción con Kubeflow

- Métodos para aplicar ML en GCP.

- Kubeflow.

- AI Hub.

- Laboratorio: ejecución de modelos de IA en Kubeflow.

Creación de modelos personalizados con SQL en BigQuery ML

- BigQuery ML para Quick Model Building.

- Demostración: enseñar a un modelo de BigQuery ML a predecir las tarifas de taxi de Nueva York.

- Modelos compatibles.

- Laboratorio (Opción 1): Predecir la duración de un viaje en bicicleta con un modelo de regresión en BQML.

- Laboratorio (Opción 2): Recomendaciones de películas en BigQuery ML.

Creación de modelos personalizados con Cloud AutoML

- ¿Porqué utilizar Auto ML?

- Auto ML Vision.

- Auto ML NLP.

- Tablas Auto ML.

Módulo 2: Preparing for the Professional Data Engineer Examination

Comprensión de la certificación Professional Data Engineer

- Establecer conocimientos básicos sobre el examen de certificación y eliminar cualquier confusión o malentendido sobre el proceso y la naturaleza del examen.

Ejemplo de casos de estudio para el examen Professional Data Engineer

- Revisión en profundidad de los casos de estudio proporcionados para la preparación del examen.

Diseño y construcción (consejos de revisión y preparación)

- Consejos y ejemplos que cubren habilidades de diseño de sistemas de procesamiento de datos, estructuras de datos y habilidades de bases de datos que podrían ser evaluados en el examen.

Análisis y modelado (consejos de revisión y preparación)

- Consejos y ejemplos que cubren el análisis de datos, el análisis y la optimización de los procesos de negocio y las habilidades de machine learning que podrían ser evaluados en el examen.

Fiabilidad, políticas y seguridad (consejos de revisión y preparación)

- Consejos y ejemplos que cubren las habilidades de confiabilidad, políticas, seguridad y cumplimiento que podrían ser evaluados en el examen.

Recursos y próximos pasos

- Recursos para aprender más sobre los temas identificados que podrían ser evaluados en el examen.

El final del curso contiene una prueba de examen de práctica sin calificación, seguida de una prueba de examen de práctica con calificación, que simula la experiencia de realización de la certificación oficial.